Nos encantan las máquinas que pueden controlar el coche, componer sinfonías y ganar juegos de ajedrez a campeones mundiales. Sin embargo, la tecnología que manejamos es cada vez más inteligente y algunos científicos y filósofos advierten sobre los peligros de una IA superinteligente incontrolable.

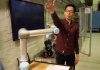

Un equipo internacional de investigadores, incluidos científicos del Centro para Humanos y Máquinas del Instituto Max Planck para el Desarrollo Humano, mostró que no sería posible controlar una IA superinteligente, utilizando cálculos teóricos.

Si alguien llega a programar un sistema de inteligencia artificial con inteligencia superior a la de los humanos, para que pudiera aprender de forma independiente y con todo el conocimiento a disposición por su conexión a internet, sería un verdadero peligro según científicos. Ya el cine nos lo había dicho con personajes como Ultron, pero ahora algunos cálculos probaron que sería una realidad.

“Una máquina superinteligente que controla el mundo suena a ciencia ficción. Pero ya hay máquinas que realizan ciertas tareas importantes de forma independiente sin que los programadores comprendan completamente cómo las aprendieron. Por lo tanto, surge la pregunta de si esto podría en algún momento volverse incontrolable y peligroso para humanidad “, dice el coautor del estudio Manuel Cebrian, líder del Grupo de Movilización Digital del Centro para Humanos y Máquinas del Instituto Max Planck para el Desarrollo Humano.

Antes de llegar a esta conclusión, los científicos exploraron cómo se podría controlar una superinteligencia. Declararon que las capacidades de una IA podría limitarse aislándola de Internet y todos los demás dispositivos técnicos para que no pueda tener contacto con el mundo exterior. Pero esto limitaría a la IA para responder a las misiones humanas.

En el estudio, los investigadores idearon un algoritmo de contención teórico que garantiza que una IA superinteligente no pueda dañar a las personas bajo ninguna circunstancia, con la posibilidad de deternerla en caso de que se vuelva dañina. Pero un análisis cuidadoso muestra que en nuestro paradigma actual de computación, tal algoritmo no se puede construir.

“Si se desglos el problema en reglas básicas de la informática teórica, resulta que un algoritmo que ordenaría a una IA que no destruyera el mundo podría detener inadvertidamente sus propias operaciones. Si esto sucediera, no sabría si el algoritmo de contención todavía está analizando la amenaza, o si se ha detenido para contener la IA dañina. De hecho, esto hace que el algoritmo de contención sea inutilizable”, dice Iyad Rahwan, director del Centro para Humanos y Máquinas.

Según estos cálculos, el problema de la contención es incomputable, así que no hay solución para una inteligencia artificial que se vuelva en contra de los humanos. Además, la investigación demostró que nunca sabremos cuándo ha llegado el momento en el que las máquinas superen nuestra inteligencia y más aun cuándo sería necesario este algoritmo de contención.